نشرت جوجل كلاود تدوينة على مدونتها تناقش فيها الخيارات المتاحة أمام المطورين عند اختيار بنية أساسية لاستضافة نماذج الذكاء الاصطناعي، مع التركيز بشكل خاص على نماذج اللغة الكبيرة (LLMs). يسلط المقال الضوء على المزايا والعيوب النسبية لكل من الحلول المُدارة ذاتيًا مثل Google Kubernetes Engine (GKE) والحلول المُدارة بالكامل مثل Vertex AI.

أحد الجوانب المثيرة للاهتمام التي أبرزتها المقالة هو أهمية فهم متطلبات ومتطلبات المشروع عند اتخاذ قرار بشأن البنية التحتية لنموذج اللغة. بالنسبة للفرق التي تعطي الأولوية لسهولة الاستخدام وسرعة التنفيذ، تقدم Vertex AI حلاً جذابًا مع ميزات مُدارة مثل القياس التلقائي والتحديثات الأمنية. من ناحية أخرى، توفر GKE تحكمًا أكبر وقابلية للتخصيص وتوفيرًا محتملاً في التكلفة للمؤسسات التي لديها فرق DevOps قوية ومتطلبات محددة.

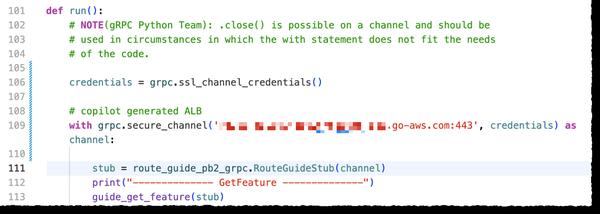

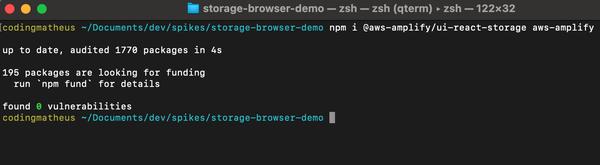

يوفر المقال أيضًا مثالًا عمليًا لتطبيق Java تم نشره على Cloud Run لاستنتاج LLM بكفاءة. يوضح هذا المثال كيف يمكن للمؤسسات الاستفادة من البنية التحتية بدون خادم لـ Cloud Run لتبسيط عمليات النشر وتحقيق قابلية التوسع. علاوة على ذلك، يتعمق المقال في خطوات نشر نموذج مفتوح المصدر على GKE باستخدام vLLM، مما يوفر دليلاً شاملاً للمؤسسات التي تتطلع إلى استضافة نماذجها الخاصة.

بشكل عام، تقدم المقالة تحليلًا متعمقًا للاعتبارات التي ينطوي عليها اختيار البنية التحتية لنموذج اللغة. من خلال تسليط الضوء على مزايا وعيوب كل من Vertex AI و GKE، يزود المقال المطورين ومهندسي DevOps ومسؤولي تكنولوجيا المعلومات بالمعرفة اللازمة لاتخاذ قرارات مستنيرة تتوافق مع احتياجاتهم الخاصة. إن التوازن بين سهولة الاستخدام والتخصيص، كما هو موضح في المقالة، أمر بالغ الأهمية لنجاح نشر LLM والاستفادة من إمكانات الذكاء الاصطناعي التوليدي.